Païou : Mandriva Linux depuis 2002. Aujourd'hui, c'est Mageia Linux

On se lasse de tout, sauf de comprendre.

Attribué à Virgile.

26 janvier 2013 : Nouvelle page.

Pour : un esprit un peu curieux.

En fait, tout a commencé lorsque je me suis demandé quels greffons de gstreamer je devrais installer.

Le son, la vidéo sont les composants essentiels des fichiers multimédia.

Lorsqu'il s'agit de choisir un lecteur multimédia, il est judicieux de se demander ce qu'il doit effectivement lire.

Tout comme le son, la lumière est tout d'abord une sensation. Votre cerveau perçoit, après plusieurs transformations, un phénomène physique. Cette perception peut être aussi bien agréable comme agressive. Il peut s'agir des dernières lueurs d'un coucher de soleil tout comme un flash qui vous éblouit. Mais il s'agit du même phénomène physique qui en est à l'origine : une source lumineuse.

Cette source lumineuse peut être très diversifiée : le soleil, une nuit étoilée, une lampe électrique, une vague lueur dans le brouillard, écran de l'ordinateur ... Dans tous les cas, il s'agit toujours d'une onde qui se propage et qui est émise par la source lumineuse, un peu comme les ondes sonores. Mais la nature de ces ondes est très différente.

La lumière a, à la fois,

Et, pour arriver jusqu'à votre œil, cette onde emprunte une route qui est le plus souvent l'air environnant, mais qui peut également être un autre support gazeux, certains liquides, certains solides et même le vide.

Un article très intéressant sur la lumière :

La source lumineuse émet donc une onde électromagnétique. Elle est caractérisée par son intensité et par sa fréquence (ou la longueur d'onde λ qui est donnée par λ=c/f où c=célérité de la lumière, f=fréquence).

Cette longueur d'onde définit la couleur de la lumière. Elle peut être monochromatique (une seule couleur et donc une seule longueur d'onde) ou polychromatique (plusieurs longueurs d'onde). On parle de spectre lumineux dans ce dernier cas, mais l'œil ne peut pas en percevoir les composantes.

Ci-contre, le spectre visible (image du site de commentcamarche).

Ci-contre, le spectre visible (image du site de commentcamarche).

Une couleur est dite primaire lorsque le mélange avec des autres couleurs primaires permet de reproduire une grande palette de couleurs.

Il faut distinguer entre lumière émise (lampe, soleil, écran de téléviseur ou d'ordinateur ...) et lumière réfléchie (les divers objets qui nous entourent n'émettent pas de la lumière, mais réfléchissent seulement une partie de la lumière qu'ils reçoivent)

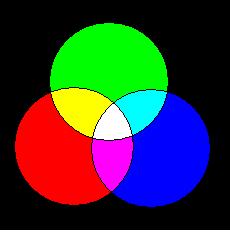

En 1807, Thomas Young s’aperçoit qu’il suffit de 3 couleurs pour reconstituer la lumière blanche : les 3 couleurs primaires RVB, ce sont le Rouge (vermillon), le Vert et le Bleu (bleu-violet). On voit sur l'image que le mélange des trois donnent la blanc, alors que le mélange de deux couleurs (toujours à parts égales) donnent le jaune, le cyan et le magenta.

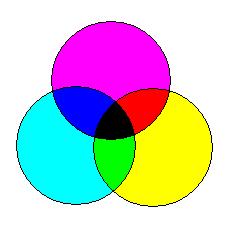

Lorsqu'un objet est éclairé par la lumière du jour, par exemple, cet objet ne renvoie qu'une partie de cette lumière. Il absorbe une bonne partie du spectre lumineux de la lumière du jour. C'est cette fraction de lumière, réféchie par l'objet, qui nous fait voir cet objet avec une certaine couleur; toutes les autres couleurs sont absorbées. L'objet soustrait donc certaines couleurs.

Comme pour les lumières émises, on trouve également trois couleurs primaires soustractives : cyan, magenta et jaune. Ces couleurs combinées permettent également de reproduire toutes les autres couleurs, pour les objets.

Ce sont les couleurs que vous trouvez pour les cartouches d'encre de votre imprimante. Habituellement on y ajoute une cartouche noire, mais c'est avant tout pour ne pas gaspiller les cartouches couleur. Il faudrait 3 gouttes pour faire du noir. Comme le noir est la couleur la plus utilisée dans l'impression, ce serait trop de gaspillage.

En informatique, les images sont décomposées en une multitude de points, plus ou moins lumineux (des pixels). Pour les images en couleurs, il y a, en fait, des triades (RVB). Ces points sont ensuite affichés sur votre écran.

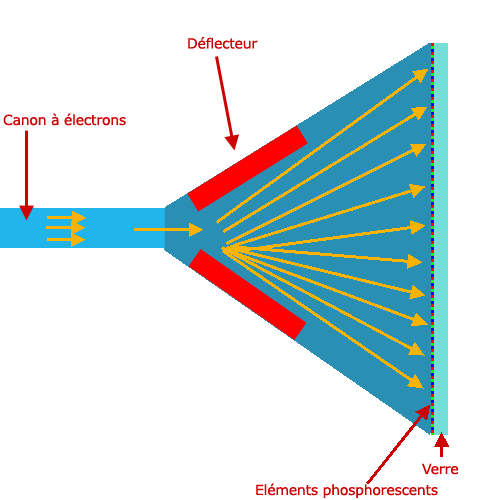

Longtemps, le tube cathodique était la principale façon d'afficher une image sur un téléviseur ou un ordinateur.

Un canon à électron envoie un faisceau d'électrons vers l'avant du tube. Des bobines électromagnétiques permettent de diriger ce faisceau, pour tracer les lignes horizontales, l'une en-dessous de l'autre.

La face avant intérieure du tube est tapissée d'une couche à base de phosphore. Le faisceau d'électrons, très concentré, arrive sur un petit point de cette couche, ce qui fait brièvement scintiller le point touché. Par ailleurs, plus le faisceau est important, plus le point sera lumineux.

Vous avez vu ci-dessus que toute couleur peut être obtenue à partir de trois couleurs primaires correctement mélangées. C'est ce principe qui est utilisé pour réaliser les tubes couleur. Il fonctionne de la même façon qu’un tube noir et blanc, mais il possède trois canons à électrons et la surface interne de la face du tube possède des triades de points, avec chaque fois des points émettant l'un une lumière rouge, l'autre une lumière verte et le dernier, une lumière bleue.

En jouant sur l'intensité de chacun des faisceaux d'électrons, chaque triade de points (également nommée pixel) arrive à produire un point avec la nuance de couleur souhaitée. C'est du moins ce que croit votre oeil. Nous laisserons de côté tous les aspects techniques pour arriver à obtenir des points élémentaires suffisamment petits et pour que les faisceaux individuels ne débordent pas sur les couleurs voisines.

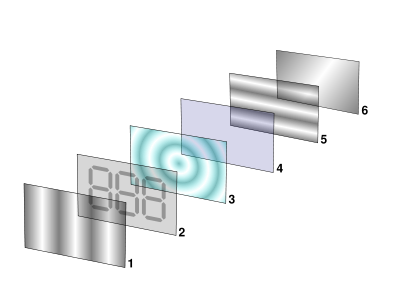

Le principe est, ici, tout à fait différent. Au départ, il y a une source de lumière blanche (la lumière blanche est un mélange de tous les rayonnements du spectre visible).

Ensuite, pour chaque point de l'écran, un tout petit "robinet" qui laisse passer plus ou moins la lumière. Chaque point de l'écran est régulièrement "visité" pour ajuster la lumière à laisser passer. L'ensemble des points forme l'image à afficher.

Ce sont les éléments 1 à 5 qui forment le robinet.

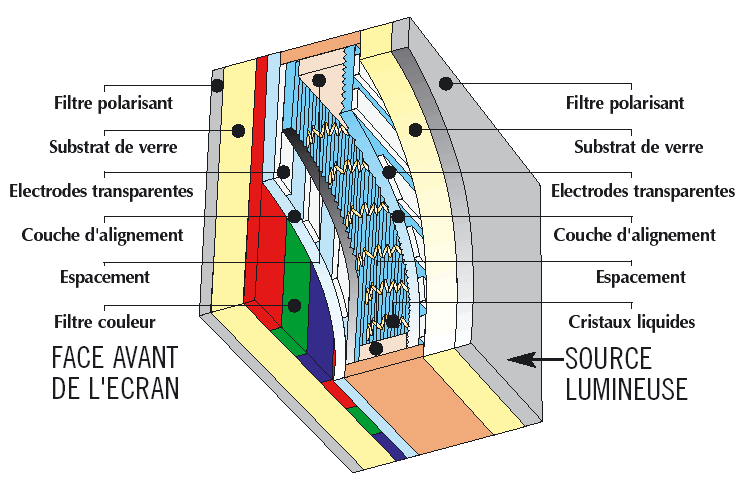

Avec un écran couleur, chaque point est en réalité constitué de trois points élémentaires (pixel), complétés par un filtre rouge pour le premier, un filtre vert pour le suivant et un filtre bleu pour le dernier. La figure ci-contre, montre une coupe d'un écran LCD, et met en évidence les bandes de filtres des trois couleurs.

C'est le champ électrique, créé entre deux électrodes, qui agit sur les cristaux liquides, comme un robinet qui laisse passer plus ou moins de lumière, au point où les deux électrodes se croisent (l'une est verticale et l'autre horizontale).

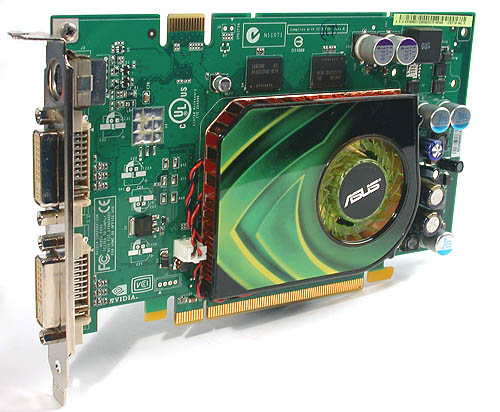

La carte graphique, parfois appelée carte vidéo, est l'élément de l'ordinateur chargé de convertir les données numériques à afficher en données graphiques exploitables par un moniteur. Cette fonction est parfois assurée par la carte-mère, mais le principe reste le même.

Pour les premières cartes graphiques, leur fonction était assez basique : l'envoi de pixels graphiques à un écran, ainsi qu'un ensemble de manipulations graphiques simples :

Les cartes graphiques récentes sont désormais équipées de processeurs graphiques spécialisés dans le calcul de scènes graphiques complexes en 3D. Ceci décharge pour autant le processeur principal.

La mémoire vidéo est chargée de conserver les images traitées par le processeur graphique avant leur affichage. Sans entrer dans les détails, plus la quantité de mémoire vidéo est importante, plus la carte graphique pourra gérer de textures lors de l'affichage de scènes en 3D.

Le frame buffer est la zone de cette mémoire qui contient l'image calculée par le processeur graphique, juste avant son envoi à l'écran.

Les performances des cartes graphiques dépendent du type de mémoire utilisée sur la carte (leur temps de réponse est déterminant pour la vitesse d'affichage des images), ainsi que de la quantité de mémoire, afin de pouvoir stocker dans le frame buffer un certain nombre d'images, avec une bonne résolution.

Il permet de convertir les images numériques stockées dans le frame buffer en signaux analogiques à envoyer au moniteur. La fréquence du RAMDAC détermine les taux de rafraîchissement (nombre d'images par seconde) que la carte graphique peut supporter.

De plus en plus de cartes graphiques et de moniteurs ne passent plus par cette conversion en signal analogique. L'image est transmise sous forme numérique à l'écran qui est capable de la traiter telle que. Une interface dite DVI (Digital Video Interface) est utilisée.

Du fait de leur grand volume, il faut compresser les données obtenues par la numérisation des images. Cette compression peut se faire sans perte de qualité ou avec des pertes plus ou moins importantes.

La page qui traite de l'encodage des images et de la vidéo :

Ces données, une fois encodées, doivent être contenues dans un fichier d'un format approprié.

La page qui traite du format des fichiers images et vidéos :